最近,你是不是也被 GPT-5 刷屏了?无论是能一口气“读”完300页文档的超长上下文,还是那堪比博士的推理能力,都让人忍不住感叹:AI真的不一样了!

无数人和中小企业团队都摩拳擦掌,准备用这个“超级大脑”来升级自己的工作和业务。但在这场狂欢之下,一个非常现实的问题也摆在了面前:谁来为这惊人的智慧“买单”?

今天,我们就来一起算算 GPT-5 背后那份,可能会让你倒吸一口凉气的算力账单。

压在普通人身上的“三座大山”

想让 GPT-5 这样的大模型在你的电脑上跑起来?这可不是多加几根内存条那么简单。你得先翻过至少三座成本大山:

硬件成本:堪比一辆车的 GPU

大模型推理,吃的不是 CPU ,而是企业级的 GPU(图形处理器),比如 NVIDIA 的H100、B200。这些卡,单张价格动辄十几万甚至数十万,而且要流畅运行 GPT-5 级别的模型,往往需要一个集群。配齐一套服务器,预算轻松超过一辆中高端汽车。

运维电力:“电费刺客”与24小时待命

这些“算力猛兽”不仅是“吞金兽”,还是“吞电兽”。它们功耗巨大,需要专业的机房、恒温恒湿的环境和强大的散热系统来伺候。一度工业用电可能不贵,但日积月累,电费账单绝对会成为“电费刺客”。更别提,你还需要专业的运维工程师来保证系统的稳定运行。

技术门槛:从入门到放弃的配置之路

即便你咬牙买下了硬件,真正的挑战才刚开始。驱动安装、环境配置、框架优化、模型部署……每一个环节都充满了普通用户看不懂的技术术语。这就像你买了一台F1赛车的发动机,却发现自己连如何点火都不知道。

AI 的“饭量”为何这么大?

看到这里你可能会问:不就是聊个天、写个文章吗?为什么AI这么“吃”资源?

让我们用一个简单的比喻来解释:

AI 的“大脑”是什么?

你可以把 GPT-5,想象成一个由上万亿个“脑细胞”连接而成的超级大脑。它的每一个“脑细胞”都存储着一小片知识,是通过阅读几乎整个互联网的内容训练出来的。

AI 如何“思考”?

当你问它一个问题,比如“中国的首都是哪里?”,这个问题就像一道电流,瞬间穿过它整个大脑网络。AI需要在一刹那间,计算出这道电流经过哪条路径(激活哪些脑细胞)得出的答案最靠谱。这个“思考”的过程,在技术上叫做“推理”( Inference )。

为什么必须用昂贵的 GPU ?

这个“思考”过程,涉及到天文数字级别的同步计算。这就好比,你需要同时让几万名小学生做简单的加减法。

○普通电脑的 CPU,像一位大学教授,能解决高难度的复杂问题,但一次只能干一件事。

○AI需要的 GPU,则像一个由几万名小学生组成的军团,他们不会解难题,但可以一瞬间同时完成几万道简单的加减法。

AI的思考方式,恰好就是“简单任务,海量并行”,所以它必须依赖GPU这个“计算军团”才能工作。这就是它“饭量”大的根本原因。

理解了这一点,你就能明白,自建AI算力,本质上就是在自己家里“组建一支庞大的计算军团”,其难度和成本可想而知。

不做“选择题”:云上推理,把超级算力放进口袋

面对这三座大山,难道个人开发者和中小企业,就真的只能站在门外,看着这场AI盛宴吗?

当然不。因为在硬碰硬之外,总有更聪明的玩法。它让拥抱AI不再是一道“买不买得起”的选择题。

这个答案就是——云上推理

这是什么意思?很简单,再打个比方:

就像你不需要买下一整座发电厂,只需按度付费就能用上电一样。你也不需要购买和维护昂贵的 GPU 服务器(自己组建“计算军团”),只需通过云服务商提供的 API 接口(一个“云端插座”),按你实际使用的计算量( Token )付费,就能享受到顶级的 AI 能力。

这种模式,把AI从一个重资产的“购买项”,变成了一个轻资产的“服务项”。它带来了三大好处:

零门槛启动:无需关心硬件,注册一个账号,获取 API 密钥,几行代码就能开始调用。

成本可控:用多少,付多少。项目初期流量小,成本就极低。业务爆发,云平台自动扩容,你只需为增长的业务付费。

技术迭代快:云平台会紧跟主流技术趋势,持续更新和扩充模型库,让你能方便地测试和切换最新的模型,而无需自己操心复杂的部署和兼容性问题。

七牛云:让 AI 的算力,像水电一样即开即用

作为一家深耕“音视频云+AI”的技术平台,我们很早就明白一个道理:AI 的普及,关键不在于模型有多聪明,而在于普通人能否用得起、用得好。我们处理过海量的视频、直播和图片,所以比谁都清楚,当这些“素材”要被AI“加工”时,背后需要多么庞大的工程支持。

为此,我们提供了两种清晰的路径来解决你的“算力焦虑”:

路径一:“拎包入住”式的AI大模型推理服务(Token API)

这适合绝大多数想快速用上AI能力的开发者和企业。我们把复杂的后台技术全部封装好,你只需要专注于创意和业务。

上手有多简单?基本就三步,以Cherry Studio为例:

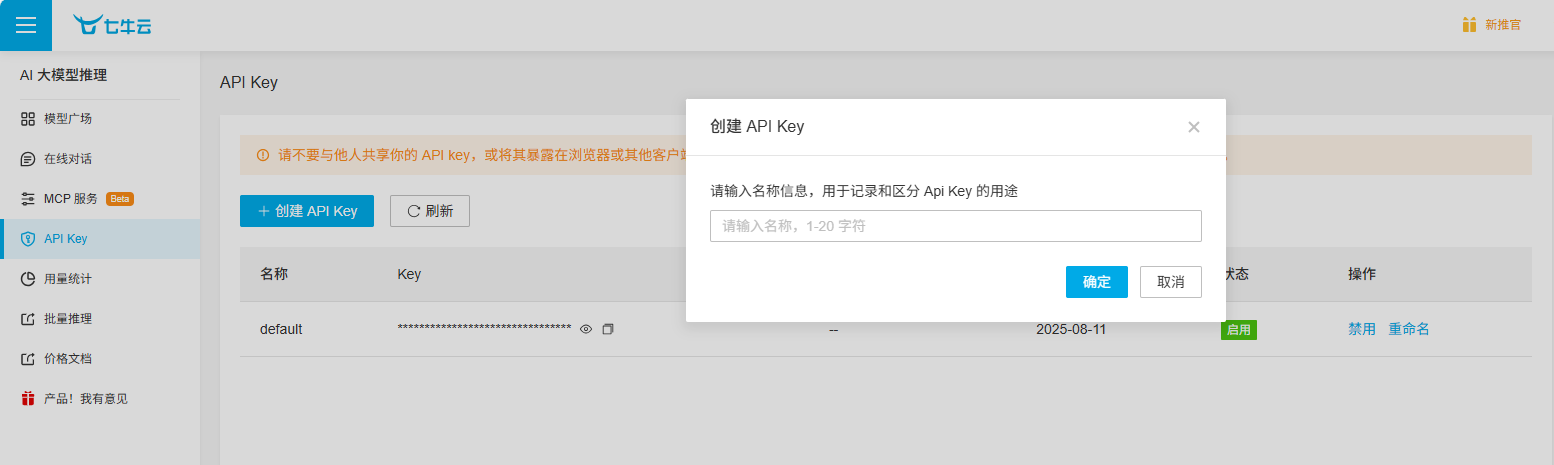

1.获取凭证:在七牛云平台注册并进入控制台,在“AI大模型推理”找到并创建一个API密钥(Token)。这是你的“云端钥匙”。

2.配置接口:打开Cherry Studio ,在设置里找到“模型服务”选项,选择“七牛云AI推理”,然后填入API 密钥。

3.模型管理:支持按需添加所需模型,灵活配置。

4.测试配置效果:点击配置界面的检测按钮,查看配置是否正确。

5.在会话中测试效果

路径二:为高阶玩家准备的GPU云服务器

如果你有更高的定制化需求,比如要用自己的数据对模型进行微调(Fine-tuning),或者部署一些特殊的开源模型,那么直接租用GPU云服务器是更灵活的选择。

这条路听起来专业,但流程也已经被大大简化了,以DeepSeek R1 蒸馏模型 GPU 主机部署为例:

1.准备环境:通过【七牛云市场】购买【专用云服务器】。

2.模型部署:七牛云提供一键 docker(推荐)、ollama、vllm 部署,您可以根据需求部署 DeepSeek 7B / 8B / 14B / 32B / 70B 以及满血 671B 版本。

3.创建知识库:在浏览器打开服务器的IP地址和端口,进入Web界面。找到“文档”,直接把你电脑里的PDF、Word等私有文件上传上去。

4.开始提问:在聊天界面,选择刚刚创建的知识库,向AI提问关于这些私有文件的问题,AI会基于你的资料来回答。

可以说, GPT-5 的出现,是AI技术的一次伟大飞跃。而以七牛云为代表的“云上推理”服务,则是将这次飞跃的红利,真正普及给每一个创新者的“阶梯”。

这真正预示着一个新时代的到来:未来,决定你能在AI浪潮中走多远的,不再是你的钱包厚度,而是你的想象力。

热门跟贴