这可是大模型应用的核心本事。

先说第一个坎,“虚假繁荣”。

现在测模型找信息,搞个“大海捞针”测试,成绩都挺亮眼。

复杂的“论述题”训练太少,模型自然就不会深度思考。

光定位准还不够,训练过程更是个老大难。

传统RL算法更绝,只要答案错了就狠狠惩罚,模型吓得不敢探索新方法,搞不好训练着就“躺平”了,早早停在半道上。

还有个绕不开的“窗口天花板”。

就算把模型的“阅读窗口”撑到256K、1M个词,碰上一整部代码仓库或者年度财报,照样不够用。

就像看小说只看了几个章节,怎么可能理解整个故事的脉络?

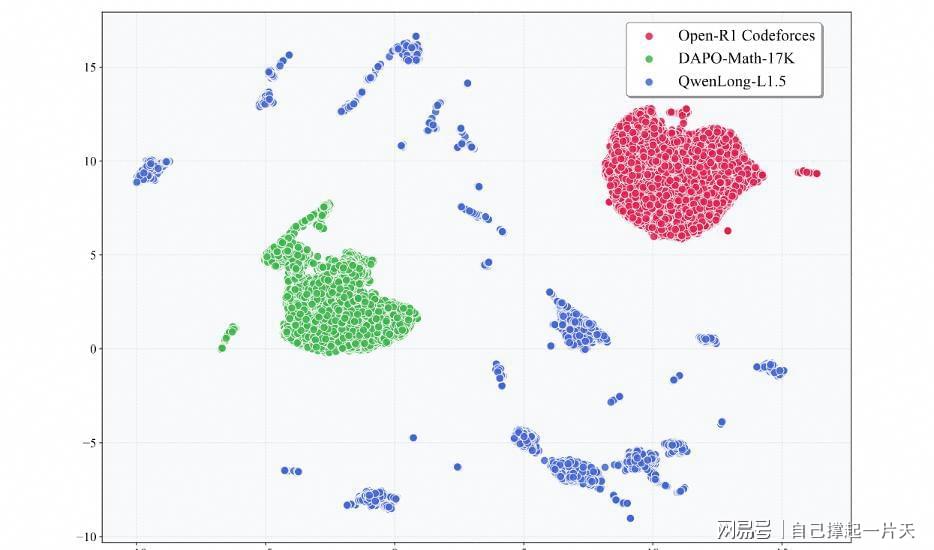

要解决这些问题,QwenLong-L1.5先从“吃”上下功夫。

模型学得好不好,“营养餐”很重要。

他们搞了套多跳推理数据合成流水线,思路挺有意思先把知识点拆成小模块,再像拼乐高似的,按知识图谱或者表格把这些模块重组,生成复杂问题。

就像老师出论述题,先拆解教材里的原子知识点,再设计需要串联多章节内容的题目。

这套“出题引擎”专门生成多跳溯源、全局推理类难题,逼着模型练深度思考。

光有好材料还得会“教”。

QwenLong-L1.5的RL优化策略算是下了功夫。

训练时不再瞎喂数据,而是从多任务类型里均匀抽样本,保证模型每种题型都练到。

奖励信号也分开算,问答任务的奖励不影响计算任务,避免“一荣俱荣,一损俱损”。

最关键的是那个自适应熵控制,模型敢尝试新方法时,就少点惩罚,要是老犯同样的错,再加重惩罚。

这就像教练教运动员,新手多鼓励,老手严要求,训练效果自然稳。

最后是给模型配个“外置大脑”。

他们搞了个记忆管理框架,相当于给模型配了本智能笔记本。

本来想靠扩大窗口硬撑,后来发现搞个“笔记本”才是聪明办法,既省内存又能记住全局信息。

这套组合拳打出来,效果确实挺明显。

我觉得这就像人学会了深度阅读,整体理解能力自然上去了。

这对处理完整代码库、年度财报来说,简直是刚需。

现在团队已经把技术细节和代码开源了,就在GitHub那个仓库里,感兴趣的可以去瞅瞅。

热门跟贴