过去两年,见证了国产视频大模型的很多突破。

从底层模型到功能到效果,一点点对Sora完成了全方位的围剿。

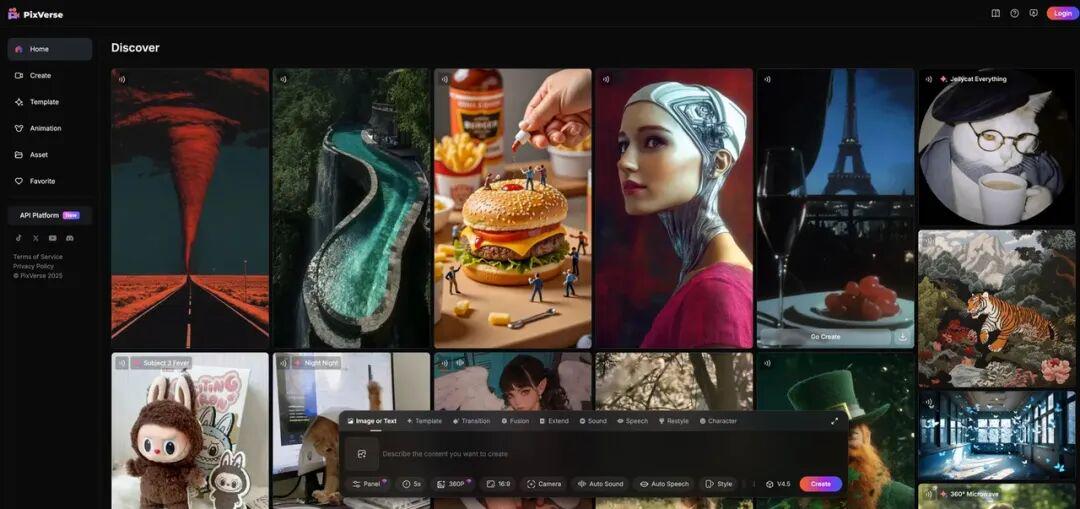

直到2026年、到现在,最让我兴奋的,是 PixVerse R1。

有点像去年用上 DeepSeek R1 的感觉——这是把游戏规则改写了。

01. PixVerse给视频下了新定义

最牛的公司,有行业定义能力。

单论视觉消费的形态,好莱坞定义了电影,YouTube定义了互联网长视频,抖音定义了短视频。

站在2026年,我想说,PixVerse给AI视频下了新的定义。

按官方的说法,这是全球首个真正意义上的「实时生成世界模型(Real-time World Model)」。

之前两三年,AI 视频领域的主旋律其实非常单一。

大家都在卷:画质更高一点,时长更长一点,人物一致性再稳一点,镜头语言再像人类导演一点。

说重要当然重要,但它解决的是同一个问题:如何更好地“生成一个结果”。

PixVerse R1让我觉得,AI视频,不是AI生图的视频版,也不是什么换个平台看AI版的抖音,是一种新形态。

就像乔布斯定义的iPhone,在产品没出来前,人们甚至不容易想明白需求到底什么样。

PixVerse 不像抖音也不像Sora,不像任何一个已经存在的产品,甚至不再把视频当成一个“静态结果”,第一次,给了一个可以实时交互的、活着的、流式生成的世界。

就好像,以前的《阿凡达》都是已经完成的、锁死的,但现在,阿凡达宇宙活了,我也能参与进去,并且没人知道接下来会发生啥。

我甚至不知道该把它叫啥,不是游戏、不是AI,像个开放的个性内容新平台。

让我能站在新世界的中央,世界随你的意图变化。

再有代入感,都不如,让我亲身来当主角,自己来下定义。

02. 视频不再是静态文件,能随时参与

过去所有的视频,不管是实拍的,还是 AI 生成的,本质上都是一样的东西:像素点的排列组合,封装成一个 MP4 或 MOV 文件。

它是死的。一旦生成,就已经结束了。

最多只能在播放层面控制快慢、暂停、回放,但无法介入“发生本身”。

不能在视频播放到一半的时候说:“等一下,让火大一点”“天黑下来”“这个角色转过身”。

PixVerse R1 现在可以实时生成了。

PixVerse R1里面设定好的宇宙观非常丰富,上天入地、神话影视,都有。

而且发现,上线一天的时间里,还在新增、还在完善,比如新加的冰山场景就很好玩。

先选择这个冰山vlog,开启体验。

打雪仗、变雪人,都很流畅。

月球漫步这个,也很有电影感,直接选中就可以。

我尝试了一下加入新角色,遇到一个“月球龙”,几秒钟视频就出现了。

操作体验非常简单易上手,大家从官网进入直接用就行,几乎不需要操作指南和教程。

很丝滑,而且每一刻的输入,都会即时影响下一刻世界的状态。

画面不是一帧一帧被播放出来的,更像现实一样,被连续地采样出来、现场此刻发生。

我的语言、情绪、意图,可以实时驱动PixVerse R1这个「现实模拟器」。

能把世界模型做成实时的,底层架构一定是硬实力。

这是从系统层、推理层、延迟控制、资源调度全栈重构的结果,不是调参能调出来的。

03. 人人都能渲染游戏?

我第一次真正被 R1 打到,是在一个非常简单、甚至有点幼稚的场景里。

我想要更多游戏化的交互,比如像宝可梦里玩法那样。

于是让它生成了一只可达鸭。

画面出来之后,我没有停下来重新生成,而是直接开口说:“让火变蓝色。”

火焰真的在画面里慢慢变蓝色。

我又说:“天黑下来,红色光。”

环境不是纯黑,而是像现实世界一样,光线逐渐变化。

我说:“它转过身。”

可达鸭转了过来,看着我。

整个过程中,没有重新生成的断裂感。

除了给定的场景,我也尝试了一下从零自己写Prompt,去创造世界。

我给的Prompt是:

一片茂盛的粉色森林,树叶像粉色的羽毛在微风中摇曳。树干是淡紫色的,挂着发光的粉色灯笼果实。一只发光的粉色小鹿(或者奇异生物)在森林中跳跃,每一步都会在地面上激起粉色的光晕涟漪。

速度响应比我想象要快,不需要切走屏幕,稍等即可。

中间我想让出现鳄鱼,以及更多场景和角色的变化,指令依循度都比较高。

整个过程就像是你在当上帝,随手一挥,世界就变了。

说实话,我现在还想象不到它怎么和具身智能结合。

但这事,我就单纯觉得好玩。它有点像小时候看动画片或者打魂斗罗游戏的那种感觉,我在一个世界里待着,然后还能通过简单的方式控制画面的走动。

传统 AI 视频,每一次修改,本质上都是一次“推翻重来”。

人是站在视频外面,对结果指指点点。

但在 R1 里,我是在视频里面,像做梦一样,梦境在流动,而你可以控制梦的走向。

那种感觉,非常接近一种“上帝视角”的造物体验。

你不是在使用工具,你是在掌控一个世界。

04. 交互的背后是技术:从按钮到意图

第二个让我后背发凉的,是交互方式的变化。

我们太习惯参数、按钮、滑杆了:亮一点、暗一点、快一点、慢一点。这是工业软件的交互逻辑。

PixVerse R1 完全绕开了这一层。不需要点按钮,也不用调参数,只需要说话。甚至都不需要说得那么精确,只要表达意图。

这就有了一个很重要的转变:用户不再是“使用者”,而是“共同创作者”。

PixVerse 自己用了一个词,叫 Playable Reality。

它既不是视频,也不是游戏,也不是虚拟世界,但又同时具备三者的特征。

PixVerse也公开了他们的技术论文:《PixVerse-R1: Next-Generation Real-Time World Model》。

核心目标是:把视频生成,从“离线片段”,变成“连续、可交互、实时响应的视觉流”。

怎么做到的呢?简单来说由三部分构成:「Omni基座模型 + 无限流式生成架构 + 实时生成引擎」

Omni基座模型,是一个端到端的原生多模态模型,把文本、图像、视频、音频统一成连续的token流。

在训练阶段,它学习了大量真实世界的视频数据,因此具备生成复杂、长时间一致场景的能力——也就是我们直观感受到的“世界感”。

生成机制上,PixVerse R1采用的是自回归生成,不是传统扩散模型那种“先算完整片段”的方式。

这意味着,它可以持续生成、无限延展视觉流,而不是只能吐出一个固定长度的视频。

所以说,表面上是交互或者形式的创新,底层还是技术,还是新的架构设计。

05. 作为前字节人,说说我眼里的PixVerse

说点更个人的视角。

我不是今天才认识爱诗科技的。V1 到 V5.5,我几乎完整见证了 PixVerse 的进化路径。

24年到25年,那时我在字节AI视频业务做产品,也让我对外部的创业团队,更加佩服,因为他们真的用远比大厂更少的资源,做出了更创新的事和更好的效果

后来,画面、叙事、稳定性一点点被补齐,画布等等能力,做漫剧都不在话下。

但直到 R1,我才意识到:他们不只在做一个视频模型产品,也在探索 AI 时代视频的终极形态。

这家公司身上有一种我在字节很熟悉、但到哪都很稀缺的气质——务实的浪漫。

他们不满足于在一个已知赛道里做到最好,更愿意在所有人都在卷结果的时候,跳出来重塑过程和定义本身。

这是非常冒险的选择。

也是只有真正的技术先行者,才敢做的选择。

2024年初,Sora横空出世。那时候,我看到了一个「AI视频新物种」。

心里有一种很矛盾的震撼。

一方面,能清楚感觉到,视频生成这条路,被硬生生往前推了一个量级。

画面、镜头、连贯性、叙事能力,第一次看起来像电影,再也不是零散的碎片。

另一方面,我又会隐约觉得哪里不对劲——它很强,但它没有生命、没有沉浸。

输入 prompt,等,出结果;再改 prompt,再等,再出结果。整个过程完全是抽卡,是在和模型的随机性做等待和对抗。

我会反复问自己一个问题:这是AI视频的终点吗?更自然的更好的交互在哪?

我们真的只是把“拍视频”这件事,从摄影机换成了 prompt 吗?

如果未来真的是虚拟现实、沉浸式世界、通用 AGI 作为叙事主体,那视频这种媒介,难道不应该是「活着的」吗?

这个问题,2025年一整年,我都没有答案。

今天,PixVerse R1 给出了参考答案。

它带来的影响,很可能不亚于去年的 DeepSeek R1——它让一种旧媒介,第一次具备了全新的交互性和游戏性。

如果说去年我们见证了“模型能力的跃迁”,那今年,我们可能正在站在视频媒介的奇点时刻。

而这一次,世界不再只是被观看。

它开始回应你了。

热门跟贴