在人工智能,特别是深度学习的浪潮中,我们习惯了 import torch,习惯了调参,习惯了看 loss 下降。

但你是否在深夜 debug 时思考过这些问题:

[吃瓜群众]为什么 ReLU 函数在

处不可导,梯度下降却依然有效?

[思考]为什么 L1 正则化能产生稀疏解,而 L2 不能,这背后的几何与测度意义是什么?

[思考]KL 散度(Kullback-Leibler Divergence)到底度量了什么?它的数学本质——Radon-Nikodym 导数又是何方神圣?

[思考]通用近似定理(Universal Approximation Theorem)凭什么保证神经网络能拟合任意函数?

[狗头][狗头]

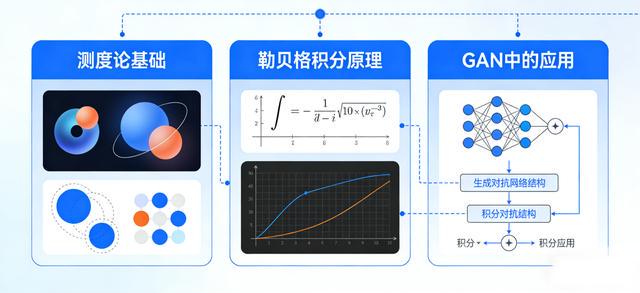

这些问题的答案,不在微积分里,而在实变函数(Real Analysis),特别是测度论(Measure Theory)与勒贝格积分(Lebesgue Integration)之中。

如果说微积分是 AI 的招式,那么实变函数就是 AI 的内功。今天,我们不谈枯燥的定理证明,只谈它们如何支撑起现代 AI 的大厦。

[思考]

一、 为什么要抛弃黎曼积分?(AI 数据的复杂性)

大一高数学的积分叫“黎曼积分”(Riemann Integral)。它的逻辑是竖着切:把定义域分成小份,算矩形面积。这要求函数必须足够“连续”和“漂亮”。

但在 AI 领域,数据和函数往往是“丑陋”的:

1高维稀疏数据: 图像、文本嵌入动辄成千上万维。

2奇异分布: 比如 ReLU 激活后的输出,在 0 处堆积了大量的概率质量(Probability Mass),而在正半轴却是连续的。这是一种“离散+连续”的混合怪胎。

3分形与极限: 神经网络的训练过程是一个函数序列逼近的过程,黎曼积分在处理极限交换(即:积分的极限是否等于极限的积分)时条件极其苛刻。

[打脸][打脸]

实变函数的救赎:

勒贝格积分(Lebesgue Integral)采用横着切的逻辑(按值域划分)。不管你的定义域(输入数据)多么支离破碎,只要输出值相近,就归为一类测量其“大小”(测度)。

[微笑][微笑]

AI 启示录:

概率论的严格公理化基础是测度论。在 AI 中,我们处理的所谓“概率分布”,本质上都是测度。没有测度论,在这个混合了离散与连续变量的高维空间里,我们甚至无法定义“期望”(Loss 函数的基础)。

[哈欠][哈欠][哈欠]

二、 测度论:重新定义“大小”与“几乎处处”

在实变函数中,有一个核心概念叫“测度为零”(Measure Zero)。

在深度学习中,我们常说“几乎处处可导”(Almost Everywhere Differentiable)。

[微笑][微笑]

①现象: ReLU 函数

处不可导。

②实变解释: 在测度论看来,单点集合 {0} 的勒贝格测度为 0。在积分和概率的意义下,零测集可以被完全忽略。

③AI 应用: 这就是为什么我们在训练神经网络时,从来不担心权重恰好落在 0 这一点上导致程序崩溃。因为在概率空间中,落在零测集上的概率为 0。

[哈欠][哈欠][哈欠][哈欠]

Dropout 与 稀疏性:

当我们使用 Dropout 时,本质上是在构造一个随机的测度空间。实变函数告诉我们,只要不改变整体的测度性质,神经网络的鲁棒性就能得到理论保证。

[吃瓜群众][吃瓜群众][吃瓜群众]

这看着眼熟吗?这正是机器学习中损失函数和正则化项的来源。

四、 Radon-Nikodym 导数:生成模型的基石

这是实变函数中最精彩的定理之一,也是现代生成模型(Generative Models)的灵魂。

进阶: 后来 Wasserstein GAN 的提出,正是利用了最优传输理论(Optimal Transport),这是测度论的更高级应用,解决了测度支撑集不重合的问题。

[吃瓜群众][吃瓜群众][吃瓜群众][吃瓜群众]

五、 收敛定理:深度学习为什么能“学”到东西?

我们在训练模型时,Loss 震荡下降,最后趋于稳定。但在数学上,函数序列的收敛有很多种:一致收敛、点点收敛、依测度收敛…

实变函数中的控制收敛定理

(Dominated Convergence Theorem)和单调收敛定理,是保证我们能交换“求导”和“积分(期望)”顺序的基石。

如果这个等号不成立,梯度的反向传播(Backpropagation)就没有数学依据。是实变函数给出了这一操作合法的充分条件——只要神经网络的梯度被某个可积函数“控制”住(通常通过激活函数的有界性或 Lipschitz 连续性来保证),我们就可以放心地进行 SGD(随机梯度下降)。

[哈欠][哈欠][哈欠][哈欠]

尾声:

虽然在工程实践中,我们不需要每天手推勒贝格积分,但实变函数决定了 AI 算法的上限。

①当你理解了测度,你就能理解为什么数据清洗如此重要(去除噪声造成的奇异点);

②当你理解了

空间,你就能设计出更符合任务特性的 Loss 函数;

③当你理解了 Radon-Nikodym 导数,你就能看懂 Diffusion Model 背后复杂的概率转移推导。

[吃瓜群众][吃瓜群众][吃瓜群众]

(注意区分文中正斜体)

热门跟贴